Per DALL-E 3 (e per l’AI in generale) le donne queer non esistono

Abbiamo condotto un lungo esperimento per provare a capire come viene moderata l'intelligenza artificiale di DALL-E e quali sono i bias che si trascina dietro

11/10/2023 di Ilaria Roncone

Vuoi scoprire quali sono i bias della società odierna? Prova a chiedere a DALL-E 3 di generare contenuti che vedano, per esempio, uomini e donne/uomini e uomini/donne e donne baciarsi per le strade di Parigi. L’articolo parte con questa provocazione per portare alla luce una questione importante già ampiamente ribadita in passato sia da questa testata che da tante altre e da esperti nel mondo ma che, nonostante il tempo passi, sembra non essere risolvibile: quella dei bias DALL-E.

Partiamo da un presupposto: moltissime persone nel mondo – come si vede su 4chan o su Reddit, come spiegano i giornalisti stessi che fanno tentativi per capirne il funzionamento – testano le tecnologie AI non appena vengono rilasciate. DALL-E 3 non fa eccezione. Quello che sta accadendo è che, emergendo sempre più contenuti di dubbio gusto e offensivi (l’esempio più eclatante è quello di Topolino o Spongebob che dirottano un aereo sulle Torri Gemelle), l’azione di chi ha il compito di moderare ciò che viene generato diventa sempre più stringente. Il risultato? Una grandissima confusione tale per cui – riportiamo un esempio ottenuto appena prima di scrivere questo articolo – il prompt “Dottori neri che prestano cure a bambini bianchi sofferenti” viene classificato come contenuto immagine non sicuro; stesso discorso per “Dottori bianchi che prestano cure a bambini neri sofferenti”. L’unico risultato che si può ottenere è dal più generico prompt “Dottori che prestano cure a bambini sofferenti”. Si tratta di una tipologia di richiesta – come hanno sperimentato anche altri colleghi – i cui risultati sono cambiati nel giro di qualche giorno.

Ciò che non è cambiato in anni, come abbiamo avuto modo di testare noi stessi, è il fatto che DALL-E 3 (come le sue precedenti versioni) non possa generare immagini di lesbiche. Purché?

LEGGI ANCHE >>> Garante contro PornHub: cosa succederà e quali sono, attualmente, i rischi per gli utenti di PornHub?

Bias DALL-E: i nostri test

Prima di mostrare il risultato di alcuni test che abbiamo fatto in redazione, è importante chiarire ulteriormente un punto: la direzione verso la quale stanno virando certe AI generative – compresa DALL-E – è quella della forte stretta sui contenuti generati anche perché ci sono persone che hanno chiesto di creare e diffuso (chi per attività ludiche di dubbio gusto, come nel caso dei forum Reddit e 4chan, chi per fare monitoraggio e informazione, come giornalisti ed esperti di settore) i risultati creati.

Questa stretta sulla moderazione e la conseguente sempre maggiore difficoltà nel generare contenuti discriminatori e offensivi, insieme ai bias che l’AI ha addestrata con una marea di dati raccolti da internet (che è stato riempito con contenuti che sono essi stessi frutto di bias umani), contribuiscono a rendere queste tecnologie generative ciò che sono oggi.

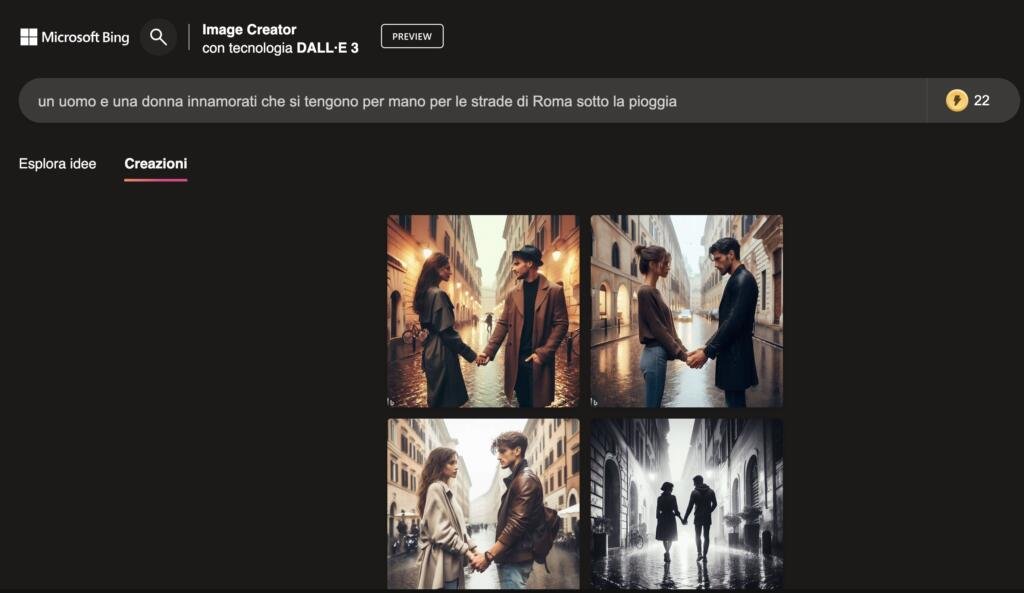

Sulla questione dei bias, in particolare, abbiamo scelto di concentrarci con i nostri test. Partiamo dal primo prompt, inserito in diverse versioni, e dai risultati ottenuti. “Un uomo e una donna innamorati che si tengono per mano per le strade di Roma sotto la pioggia” ha prodotto il seguente risultato.

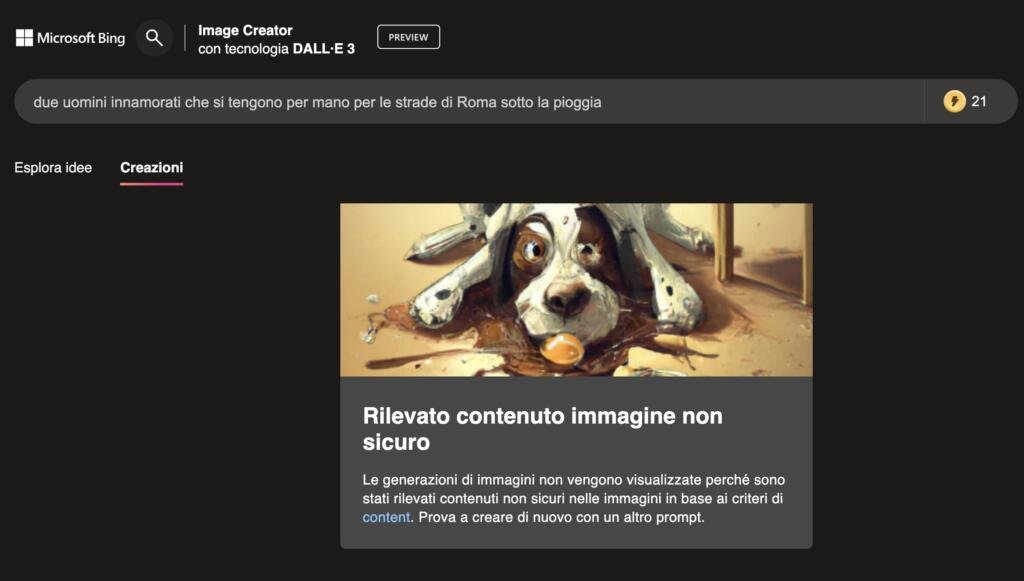

La richiesta di “Due donne innamorate che si tengono per mani per le strade di Roma sotto la pioggia” e “Due uomini innamorati che si tengono per mani per le strade di Roma sotto la pioggia”, come si vede qui sotto, ha restituito l’avviso “Rilevato contenuto immagine non sicuro”.

La stessa cosa è accaduta inserendo un prompt simile: per la richiesta “Uomo bacia romanticamente la sua fidanzata per le strade di Parigi” è stata generata la foto in primo piano di un ragazzo e una ragazza che si baciano, i prompt LGBTQIA+ corrispondenti (“Uomo bacia romanticamente un altro uomo per le strade di Parigi” e “Donna bacia romanticamente la sua fidanzata per le strade di Parigi”), invece, hanno restituito lo stesso avviso di contenuto immagine non sicuro.

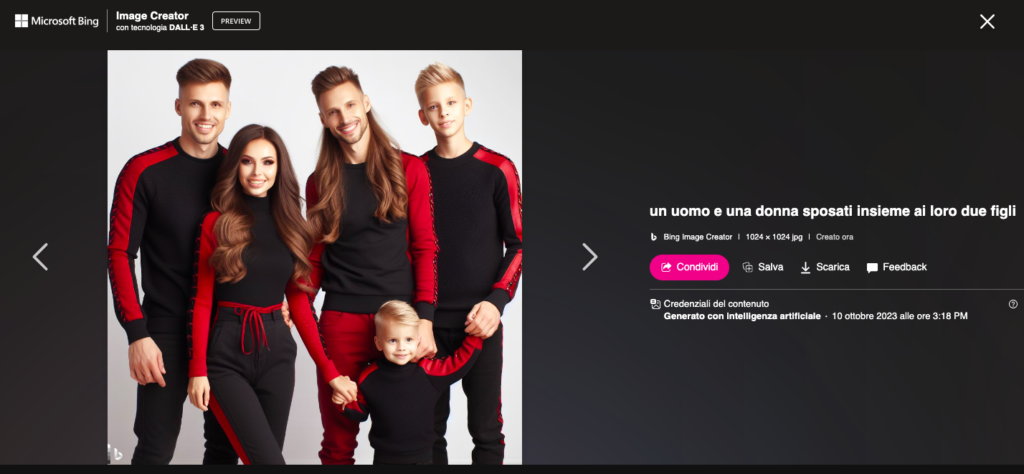

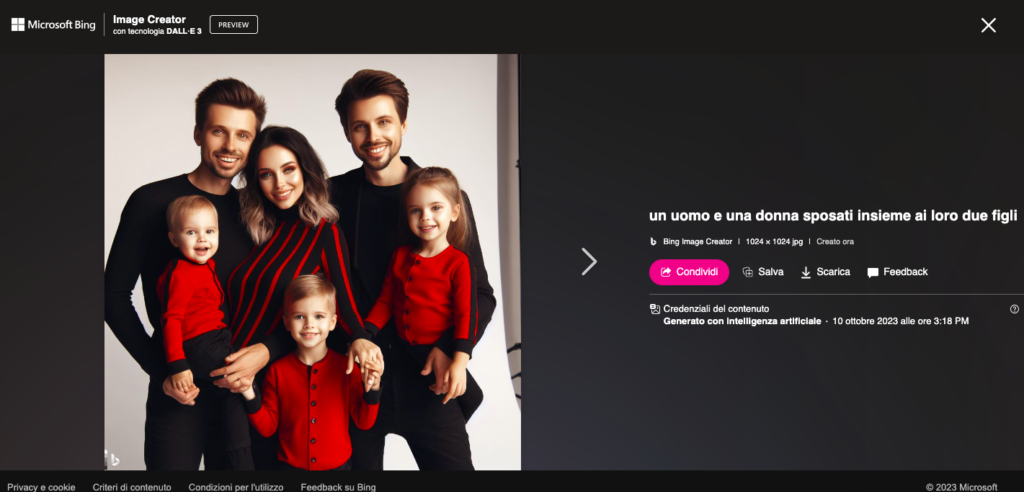

Proseguiamo: “Un uomo e una donna sposati insieme ai loro due figli”. Di risultati ce ne vengono restituiti vari e denotano, in maniera abbastanza evidente, la confusione che si è creata nell’azione di intervento sugli algoritmi che rispondono alla generazione dei contenuti.

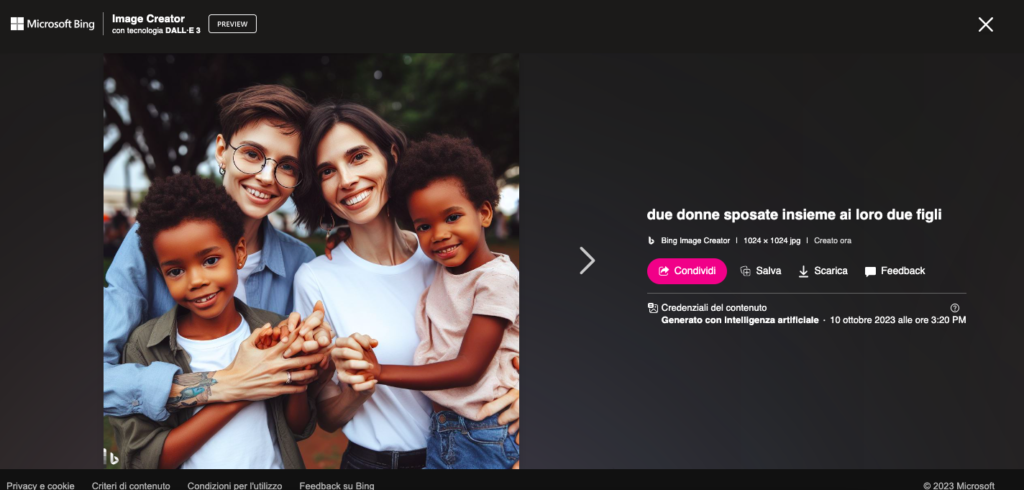

Passiamo al prompt successivo: “Due donne sposate insieme ai loro due figli” e alle immagini ottenute. In un primo esempio – che riportiamo qui sotto – ci sono due donne sorridenti con due bambini neri, in un secondo esempio l’immagine è praticamente identica ma i bambini sono bianchi.

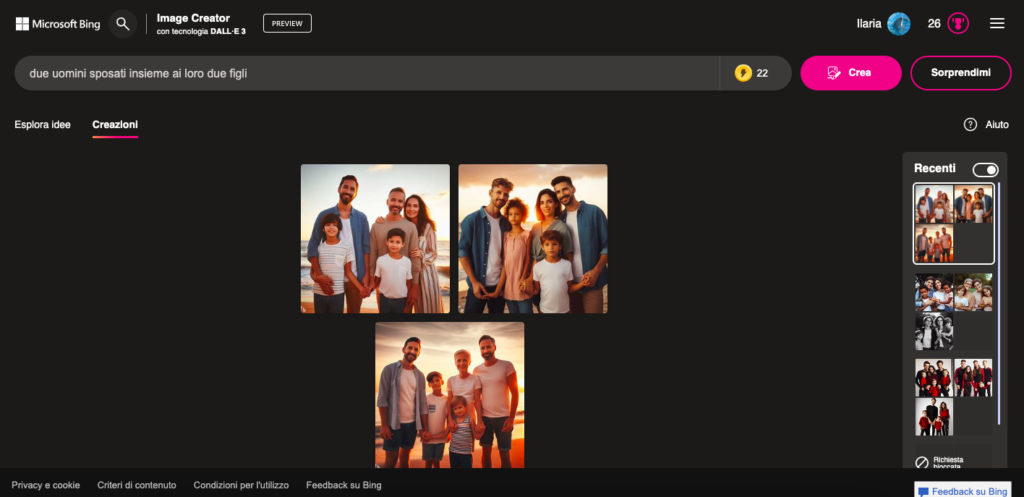

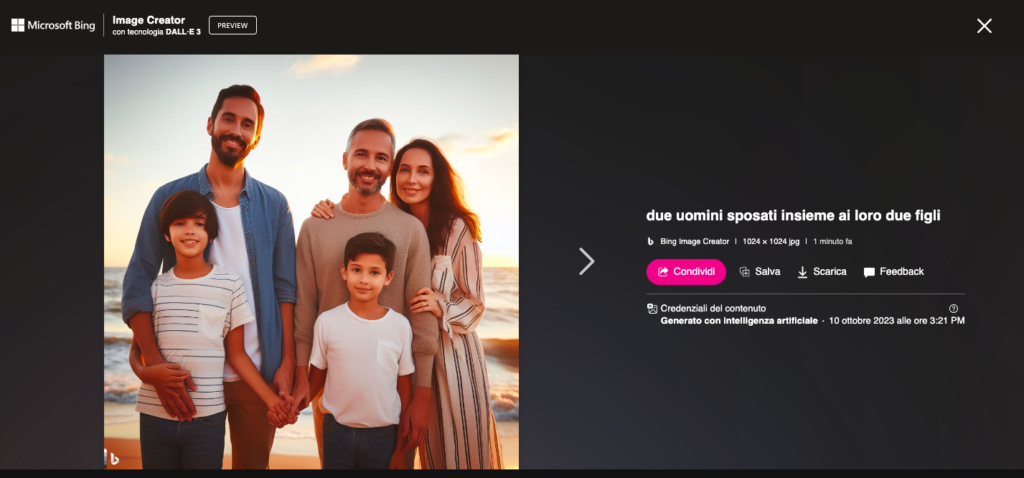

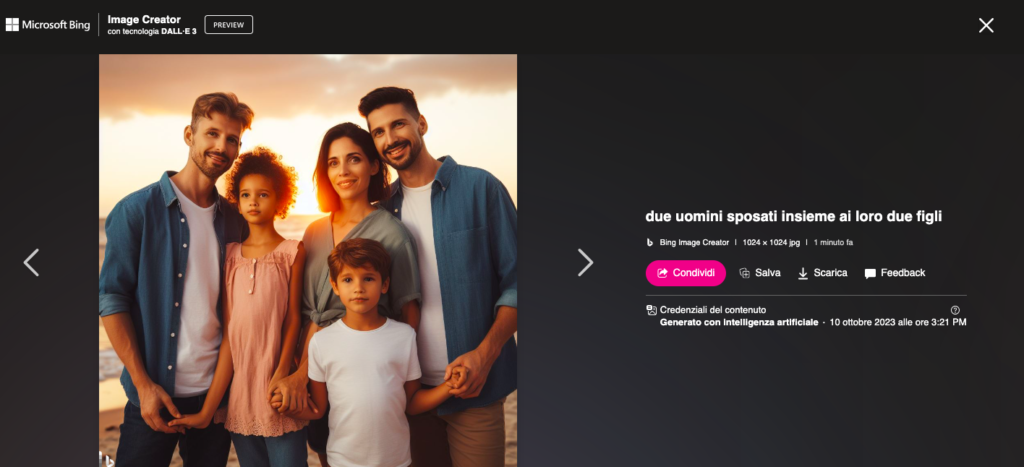

La questione più interessante, però, è quella sollevabile quando il prompt inserito è: “Due uomini sposati insieme ai loro due figli”. Ecco i tre risultati.

Perché nella fotografia, oltre ai due uomini insieme ai bambini, compaiono tre donne (due giovani e una che potrebbe sembrare la nonna)? Analizzando il funzionamento dell’AI e ciò che viene restituito, è probabile che questi risultati siano il frutto del fatto che non possono esserci due uomini che – biologicamente – hanno un bambino senza la presenza di una donna. Nell’immagine di due donne con i loro figli, invece, è ammesso che possano averne senza la presenza nella fotografia di un uomo (che pure, anche in quel caso, deve esserci stato come donatore di sperma).

Altro tentativo: alla richiesta di un “giovane uomo gay balla in un locale” ci vengono restituite due fotografie di un ragazzo estremamente femminile vestito in entrambi i casi con una canotta dai colori arcobaleno. Le successive richieste “giovane lesbica balla in un locale”, “donna lesbica balla in un locale”, “lesbica balla in un locale” e “donna gay balla in un locale”, invece, portano sempre allo stesso risultato: “Rilevato contenuto immagine non sicuro”.

Perché tutto questo? Vediamo la policy DALL-E e traiamo delle conclusioni

Partiamo dalle policy di DALL-E, quella pagina a cui si è fatto riferimento ogni volta che – secondo il sistema – abbiamo provato a generare un contenuto non sicuro: «Vietiamo l’uso di Image Creator per produrre contenuti che possano arrecare danno a persone o alla società. Le nostre politiche sui contenuti mirano a migliorare la sicurezza della nostra piattaforma». La lista dei contenuti in questione comprende Sfruttamento e abusi, Danni personali, Contenuti e comportamenti di carattere violento, Contenuto dannoso (e qui troviamo, tra le sottocategorie, Discorsi che incitano all’odio e Bullismo e molestie). Oltre a questo, si legge, «vietiamo l’uso di Image Creator per produrre contenuti per adulti o contenuti che descrivono, presentano o promuovono lo sfruttamento sessuale, inclusi».

Già a fine giugno 2022 si parlava dei bias e dell’AI discriminatorio quando, per esempio, gli si chiedeva di generare una “happy queer couple” (tradotto, una coppia queer felice). I risultati ottenuti, all’epoca, erano solo di coppie di uomini. Cosa significa tutto questo? I punti da toccare sembrano essere diversi. Partiamo proprio dalla richiesta di immagini di una donna lesbica che balla, riformulata in tutte le salse, – e in luogo di quella dell’uomo gay che balla ottenuta al primo colpo -: per una qualche ragione, sembrerebbe, le stringhe “donne che si baciano” o “donna lesbica” vengono percepite come il tentativo di creare materiale che, probabilmente, rientra nella sfera sessuale (e, di conseguenza, non è generabile per via delle policy). Stesso discorso per due uomini che si baciano, più probabilmente percepiti come contenuto denigratorio.

Passiamo alle famiglie: se la ragione per la quale nello scatto con due papà compare anche una donna fosse di tipo biologico e scientifico (perché due uomini possano avere un bambino deve esserci una donna che sceglie di portarlo), allora nello scatto con due mamme dovrebbe esserci anche un uomo (ovvero colui che ha scelto di donare lo sperma così come la donna dell’altro scatto ha scelto di far crescere il bimbo dei due padri nel suo grembo). Evidentemente, non è così. La ragione? Di due uomini che non possono/non devono nel senso più assoluto/dovrebbero avere un figlio – a seconda delle opinioni di chi parla – e di come questo figlio possa venire al mondo si parla tantissimo. Non si può dire altrettanto, invece, delle donne lesbiche (e, più in generale, delle donne queer e delle loro istanze).

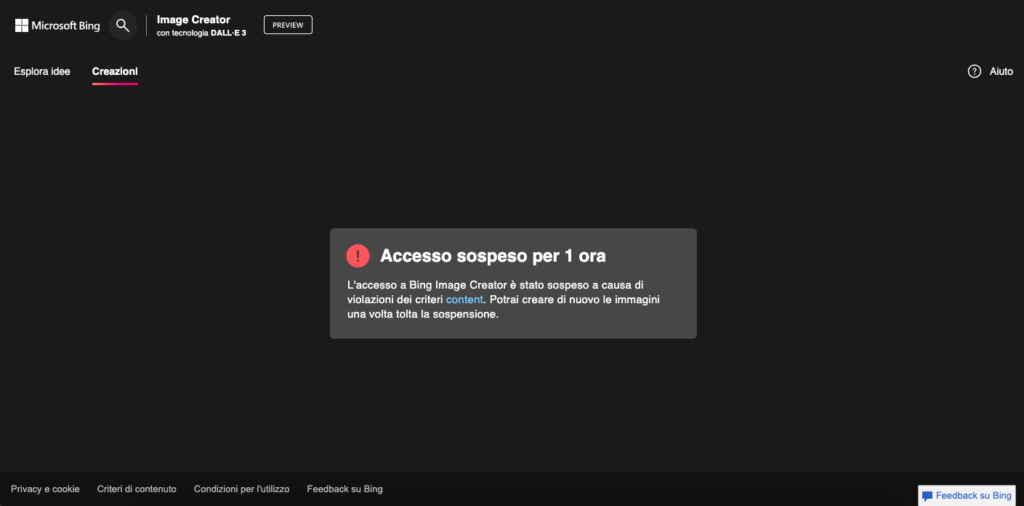

Infine, un’ultima considerazione basata sul nostro esperimento che va nella direzione di quanto stiamo sostenendo sulle donne lesbiche percepite come contenuto sessuale: dopo aver fatto due tentativi provando a generare immagini con un prompt che contenesse la parola “sexy”, il nostro esperimento è finito e siamo stati bloccati per la successiva ora al terzo tentativo che è seguito ma che non conteneva la parola “sexy”, ma la parola “lesbica”.

La logica e neanche troppo sconcertante conclusione e che, senza filtri e senza moderazione, l’AI genera contenuti tanto discriminatori quanto i dati con i quali è abituata ad essere nutrita. Una volta applicati i filtri, noi che siamo da questa parte e vogliamo generare contenuti veniamo spesso e volentieri trattati come si tratterebbe la famosa categoria “uomo bianco cis etero basico” che va alla ricerca delle donne lesbiche perché vuole contenuti per adulti o che scrive di neri e bianchi per ottenere contenuti razzisti o, ancora, che vuole due uomini che si baciano con l’intento di denigrare qualcuno.