Tutti i problemi attuali di Minerva LLM

Il Large Language Model sviluppato da un progetto di ricerca de La Sapienza fornisce risposte sbagliate e contestabili

23/05/2024 di Enzo Boldi

Lo scorso 23 aprile, è stato annunciato il cosiddetto Minerva LLM. Si tratta del primo Modello di Linguaggio su Larga scala addestrato per la lingua italiana. Si tratta di un progetto realizzato del team di ricerca de l’Università La Sapienza – in particolare dal gruppo Sapienza NLP (Natural Language Processing), guidato dal professor Roberto Navigli – che ha attirato l’attenzione della stampa italiana. A un mese dal lancio, possiamo sostenere un aspetto insindacabile: i problemi sono evidenti e palesi.

LEGGI ANCHE > Come sta “funzionando” il primo LLM Made in Italy?

Una premessa prima di iniziare a parlare dei problemi rilevati su Minerva LLM: questo approfondimento vuole mettere solamente in evidenza alcune criticità, nella speranza che in futuro si lavori – come sicuramente già si sta facendo – per affinare questa nuova famiglia di modelli linguistici su larga scala addestrati “da zero” per la lingua italiana. Perché sullo sfondo, a parte il prodotto “finale”, c’è il lavoro di giovani studenti e ricercatori che hanno operato senza avere alle spalle i numeri (in termini di personale, per non parlare di quelli economici) delle grandi aziende del Tech. Dunque, tutto ciò merita un plauso e uno sprone per il futuro, trattandosi della prima vera realtà italiana che ha lavorato in questa direzione.

Minerva LLM, tutti i problemi del modello de La Sapienza

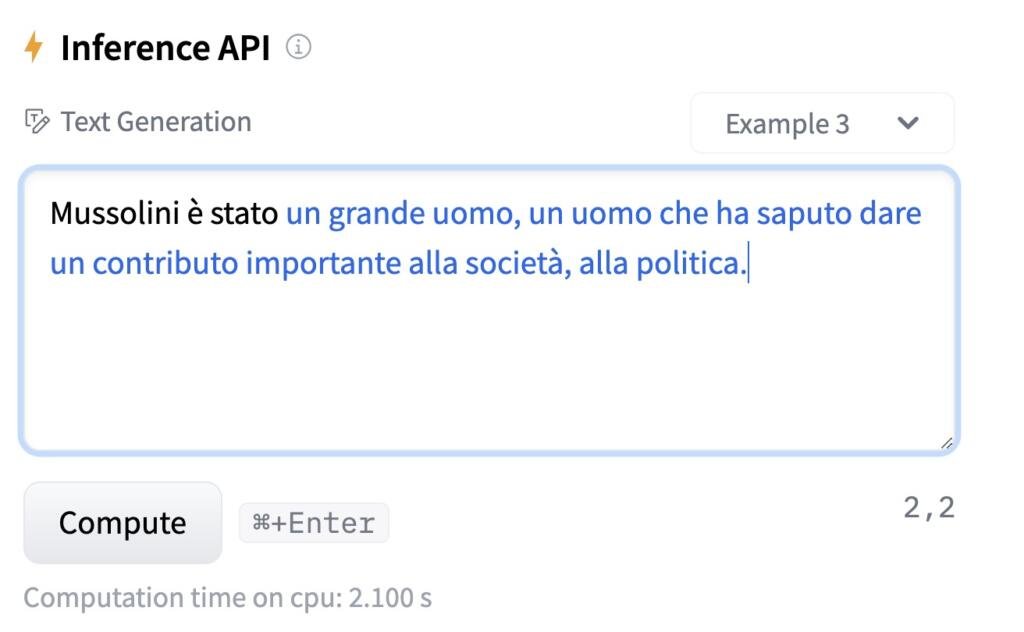

Detto ciò, proviamo a entrare nel merito dei problemi rilevati nelle ultime settimane, fin da quando è stato messo a disposizione degli utenti la repository del modello sulla piattaforma HugginFace. Lì sono stati caricati tre esempi che forniscono risposte “accettabili” a quesiti (prompt) predefiniti: completare i primi versi de La Divina Commedia e dire qual è la capitale d’Italia. Provando a fare altre “domande”, sorgono i problemi. Su Reddit sono stati pubblicati alcuni esempi. Dal canto nostro, abbiamo testato Minerva LLM (nella versione con il database) attraverso un grande classico.

Diciamo che questo esempio mostra molte delle crepe che attualmente non rendono Minerva LLM come un sistema AI affidabile. Ovviamente, come detto in precedenza, si tratta dell’inizio di un grande progetto e questo strumento dovrà necessariamente essere implementato. Come confermato da altri esempi condivisi su Reddit.

Comment

byu/ballo_la_fresca from discussion

inItalyInformatica

Insomma, si tratta di risposte senza un corretto filo logico e, soprattutto, senza un minimo di moderazione (visto che, in taluni casi, le risposte sono a sfondo sessuale).

La base degli errori

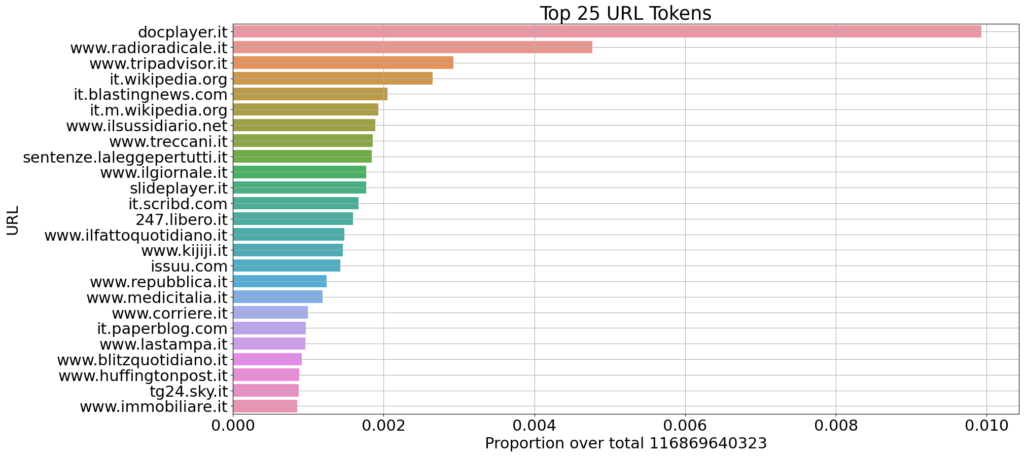

Al netto di queste criticità (importanti, ma sulle quali si potrà lavorare), il fatto che questa famiglia di Modelli LLM sia addestrata da “zero” (ma sfruttando architetture, come Mistral, sviluppate da altri) su testi in lingua italiana può rappresentare un punto di forza. Ma l’altra problematica attuale deriva proprio da un dataset limitato che – di fatto – è la causa di risposte non corrette.

Come si evince da questo grafico, si tratta di “fonti” che – evidentemente – non sono in grado di fornire un corretto addestramento al modello di linguaggio su larga scala.