Stable Diffusion, come funziona l’intelligenza artificiale di un generatore d’immagini

Cerchiamo di capire, attraverso una serie di esempi, come funzionano algoritmi quali DALL-E o Stable Diffusion per generare arte digitale

09/12/2022 di Giacomo Aschacher

L’intelligenza artificiale (AI) sta prepotentemente prendendo piede all’interno della nostra vita digitale soprattutto in ciò che riguarda la generazione di versioni migliorate di noi stessi all’interno dei social network. Dai filtri di Instagram alla creazione di avatar 3D, i trend si stanno spostando su tutte quelle applicazioni in grado di generare immagini artistiche o fantasy che si basano su di un mix tra foto reali e opere di fantasia recuperate all’interno di enormi archivi di immagini chiamati dataset.

Il motore in grado di generare queste immagini è un modello di algoritmi di machine learning in grado di simulare le reti neurali che consentono quindi all’AI di imparare a svolgere determinati compiti basandosi su di una mole sterminata di dati che usano, appunto, come modello. Le app in grado di generare le immagini utilizzano in particolare dei modelli generativi di “diffusione” che si basano su dataset di immagini associate a didascalie e che quindi mettono insieme una determinata immagine e un significato di ciò che è rappresentato. Gli algoritmi più utilizzati da queste applicazioni sono DALL-E, un prodotto commerciale e quindi non di libero utilizzo e Stable Diffusion, utilizzabile da chiunque perché rilasciato su licenza open-source.

LEGGI ANCHE >>> La rivolta degli artisti contro Lensa AI e le app che sfruttano le opere senza consenso

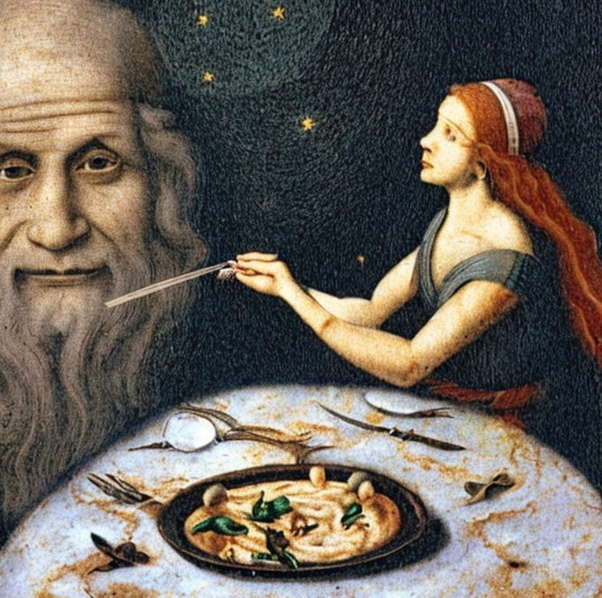

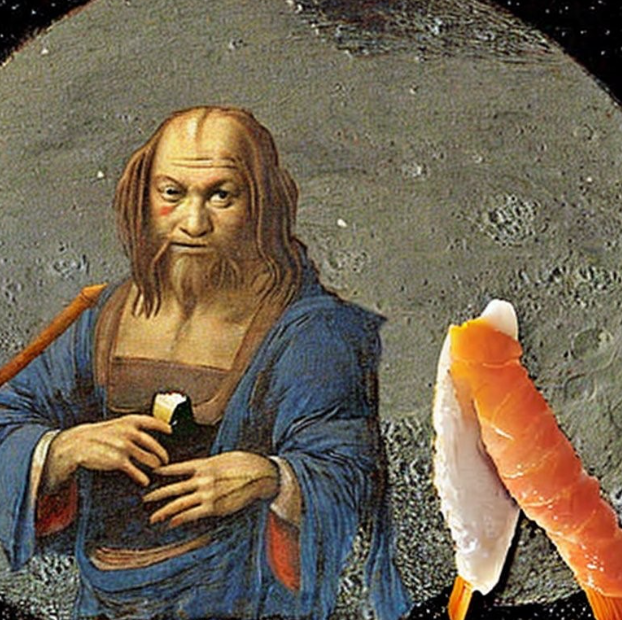

Il testo assume quindi una parte cruciale in quanto poche stringhe descrittive consentono la generazione di un’immagine univoca e originale. Inserendo, ad esempio, un testo come “Leonardo Da Vinci mangia una carbonara o del sushi sulla luna”, si ottengono immagini a metà strada tra il surreale e la pittura rinascimentale come si può vedere sotto.

Ma come funziona nello specifico un algoritmo generativo di diffusione? Proviamo a spiegarlo con un esempio semplice: pensiamo a una stanza le cui pareti e arredamento sono prevalentemente di colore bianco, una fotografia della stanza rappresenta lo stato iniziale dell’immagine. Immaginiamo che al centro della stanza viene acceso un fumogeno colorato che produce una nuvola di fumo azzurra: questo è un elemento di disturbo che si concentra nello spazio centrale della stanza. L’algoritmo generativo cerca di interpretare questo disturbo e lavora per distribuirlo all’interno dello spazio creando una serie di immagini intermedie. Ogni immagine generata è un una rielaborazione della precedente in cui il disturbo viene progressivamente diffuso e ridotto. Se l’algoritmo lavora bene, l’immagine finale sarà la stessa stanza ma interamente colorata di azzurro.

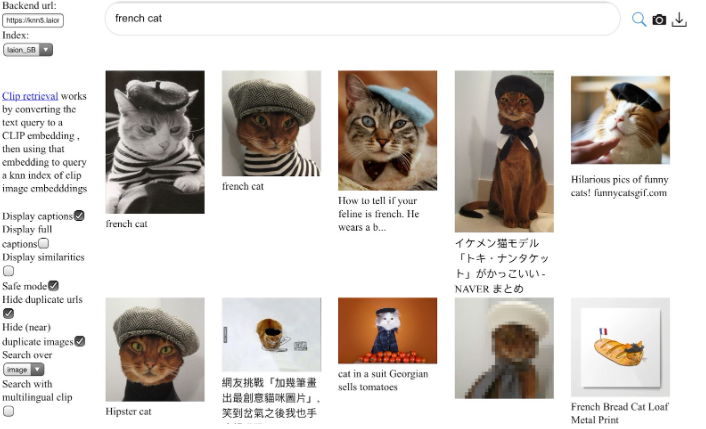

Chiaramente l’algoritmo alla base di Stable Diffusion consente di eseguire operazioni decisamente più complesse dell’esempio presentato. Come detto può interpretare un testo scritto, estrapolandone gli elementi e creando un’immagine del tutto originale attingendo da un archivio, il dataset. Il dataset da cui attinge Stable Diffusion si chiama Laion e in particolare Laion 5-b. 5-b sta per 5 miliardi di immagini (in realtà quasi 6) comprensive di didascalia.

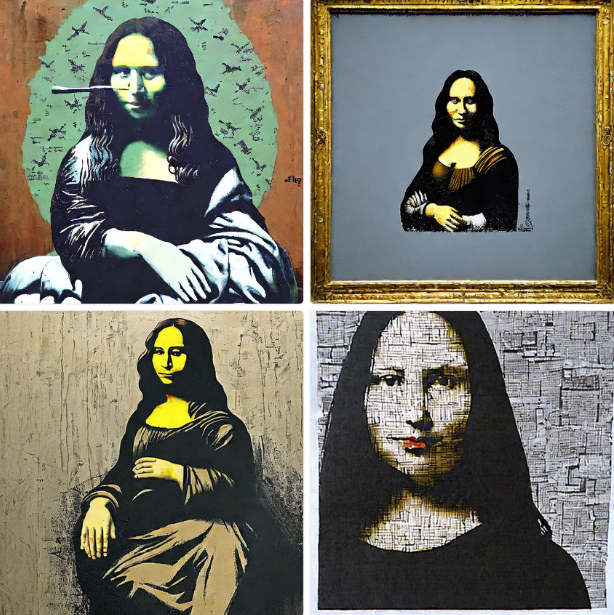

Il modello può anche essere utilizzato per generare differenti versioni di una singola immagine basandosi su dei parametri relativi, ad esempio, allo stile pittorico (immaginando, per dirne una, la Gioconda raffigurata come fosse un murales di Banksy).

Infine, l’algoritmo consente anche di rimuovere un elemento all’interno di un’immagine, sostituendolo automaticamente con un altro elemento descritto testualmente.

I campi di applicazione di un modello come Stable Diffusion al momento appaiono relegati principalmente all’intrattenimento. Le immagini generate mostrano ancora chiari elementi artefatti ma nel tempo potrebbe essere utilizzato per creare campagne pubblicitarie dinamiche per mostrare il prodotto su immagini generate in tempo reale, applicandolo al video si potrebbero creare effetti speciali e avrebbe senso l’utilizzo anche in campo architettonico, arredamento, medico, industriale ecc.

La strada per un progetto del genere è ancora lunga e piena di ostacoli, dovendo già fare i conti con le tematiche relative alla privacy delle foto caricate dagli utenti e generate dall’algoritmo e al diritto d’autore delle singole immagini archiviate all’interno del data set utilizzato. Più si perfezionerà il modello e il conseguente realismo dell’immagine, più si andrà incontro anche ad altri tipi di rischi legati alla possibile creazione di contenuti per scopi illeciti o disinformativi.