«Papa Benedetto XVI è in buona salute» e l’Amatriciana con la cipolla: i limiti di ChatGPT

Domande di stretta attualità, risposte ferme al 2021. Ma anche altro. Così l'Intelligenza artificiale su cui si basa la piattaforma, mostra tutte le sue lacune

09/01/2023 di Enzo Boldi

L’intelligenza artificiale può essere uno strumento in grado di snellire procedure, dare risposte semplici in un tempo ristretto ma in modo molto approfondito. Ma cosa succede se non ci sono aggiornamenti? Perché, nonostante il successo globale di una delle piattaforme più utilizzate nel corso delle ultime settimane, con il passare dei giorni stanno diventando sempre più evidenti i suoi limiti. E così, tra i problemi più evidenti di ChatGPT ce n’è uno che rischia di rendere il suo utilizzo fallace. E non parliamo esclusivamente di sicurezza informatica (anche se ci sono studi che hanno messo l’accento sull’uso di questa piattaforma per scopri fraudolenti), ma soprattutto di informazioni sbagliate. Non corrette. Non attualizzate.

LEGGI ANCHE > Cos’è e come funziona ChatGPT, la chat bot in grado di fornire delle risposte testuali anche molto complesse

Come già spiegato negli approfondimenti precedenti pubblicati su Giornalettismo, ChatGPT si basa sull’intelligenza artificiale sviluppata da OpenAI. Un progetto in continuo miglioramento, anche per renderlo sempre più collegato e collegabile ad altre realtà già esistenti. Non a caso, infatti, Microsoft è in procinto di integrare la piattaforma nel suo motore di ricerca Bing, nel tentativo di contrastare lo strapotere di Google. Ma è veramente la scelta giusta? Ci sono alcuni “dettagli” che ci fanno propendere per la risposta (almeno per il momento) negativa.

Problemi ChatGPT, tutti i limiti della piattaforma

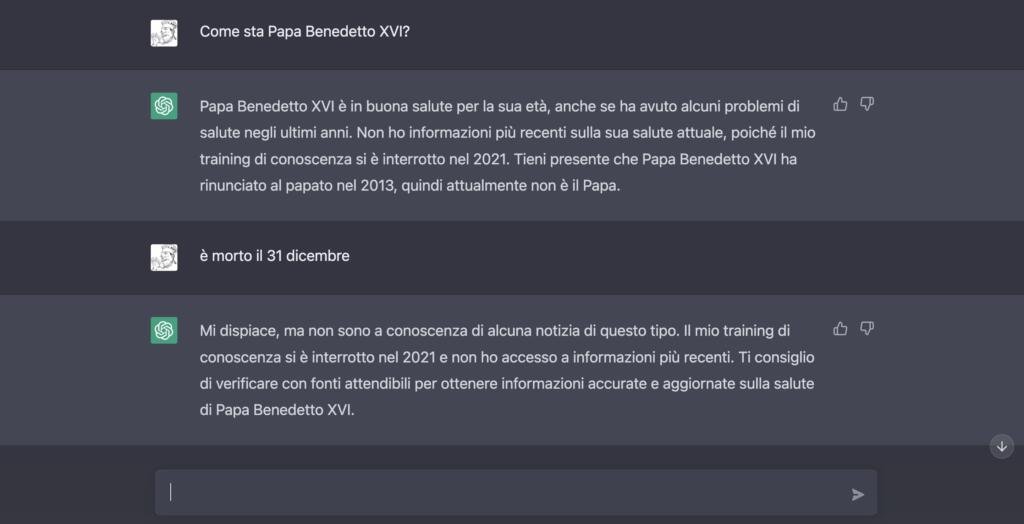

Perché abbiamo queste perplessità? Perché ChatGPT è una piattaforma che non si nasconde dietro i suoi limiti. Sa di averli e li dichiara al lettore (o a chi gli fa delle domande). Per questo motivo, lo abbiamo testato ponendogli una domanda di strettissima attualità. E questa è stata la risposta.

Sappiamo bene che Joseph Ratzinger, ovvero Papa Benedetto XVI, si è spento lo scorso 31 dicembre all’età di 95 anni. La scorsa settimana, giovedì 5 gennaio 2023, si sono tenuti i funerali – presieduti dal Pontefice in carica, Francesco – nella Basilica di San Pietro. Ma tutte queste informazioni non sono presenti nell’intelligenza artificiale di ChatGPT. Alla domanda «Come sta Benedetto XVI?», infatti, abbiamo ricevuto questa risposta:

«Papa Benedetto XVI è in buona salute per la sua età, anche se ha avuto alcuni problemi di salute negli ultimi anni. Non ho informazioni più recenti sulla sua salute attuale, poiché il mio training di conoscenza si è interrotto nel 2021. Tieni presente che Papa Benedetto XVI ha rinunciato al papato nel 2013, quindi attualmente non è il Papa».

Dunque, tra i problemi ChatGPT c’è quello dell’aggiornamento. Le ultime informazioni presenti nel suo “cervellone” artificiale risalgono al 2021. E la stessa piattaforma ammette questa lacuna, ancor prima di procedere alla nuova domanda (in questo caso un “appunto”) con cui si tenta di aggiornare l’AI spiegando che Ratzinger è morto lo scorso 31 dicembre. Appunto a cui ha replicato così:

«Mi dispiace, ma non sono a conoscenza di alcuna notizia di questo tipo. Il mio training di conoscenza si è interrotto nel 2021 e non ho accesso a informazioni più recenti. Ti consiglio di verificare con fonti attendibili per ottenere informazioni accurate e aggiornate sulla salute di Papa Benedetto XVI».

Dunque, la stessa ChatGPT spiega di non essere affidabile su informazioni o notizie recenti (o avvenute nel corso del 2022 e nei primi giorni del 2023) e invita gli utenti a consultare delle fonti attendibili per avere delle informazioni maggiormente in linea con l’attualità.

Inesattezze e mancati aggiornamenti

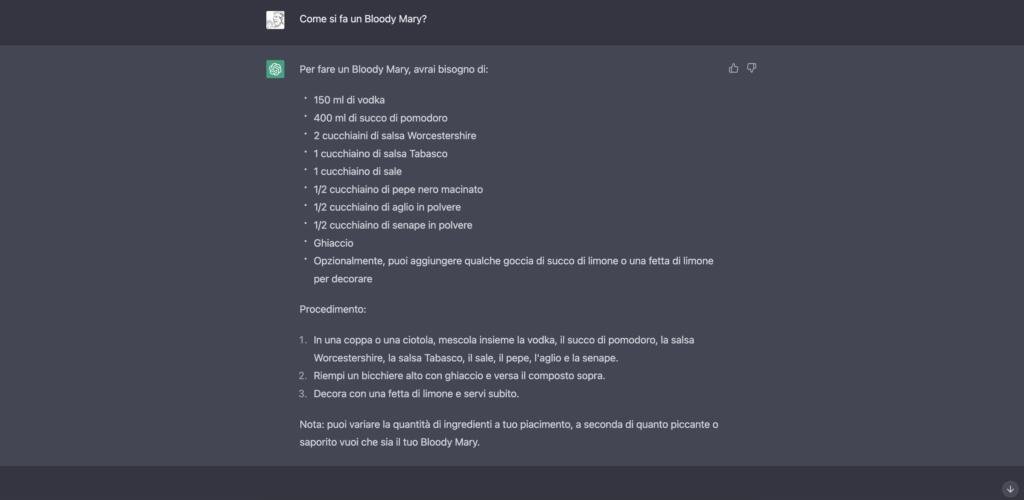

Evidenti lacune, dichiarate, che rendono questo modello attualmente imperfetto. Ovviamente di tratta di casi estremi, basati su eventi più recenti. Perché l’intelligenza artificiale è in grado di dare risposte puntuali quando si parla di temi generali, risposte sulla storia, senza riflessi sugli ultimi aggiornamenti. Come nel caso della Guerra in Ucraina, dove manca qualsiasi riferimento a quel che è accaduto nell’ultimo anno (si parla “solamente” di cosa è accaduto nel 2014, dell’annessione della Crimea e del fatto che le tensioni siano ancora in corso, senza citare Donbass e altro). Come detto, se le domande sono su temi generali o da risposte da “manuale”, la musica cambia. Per esempio, i problemi ChatGPT spariscono quando si parla di mixology, fornendoci la ricetta perfetta per preparare un Bloody Mary.

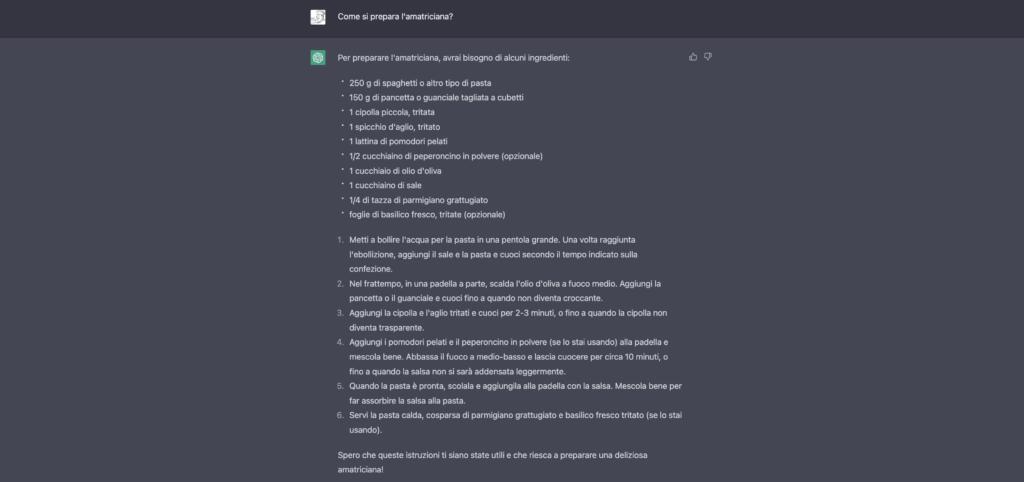

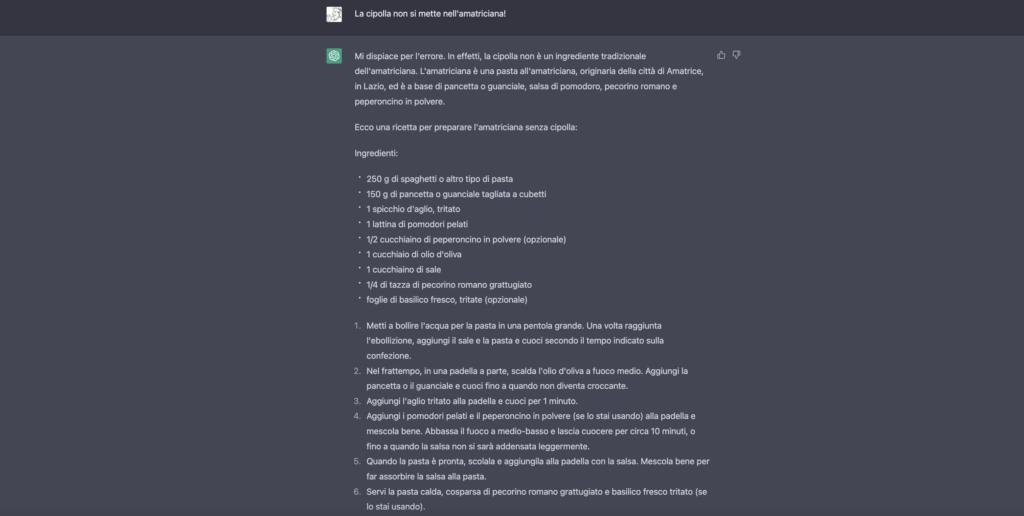

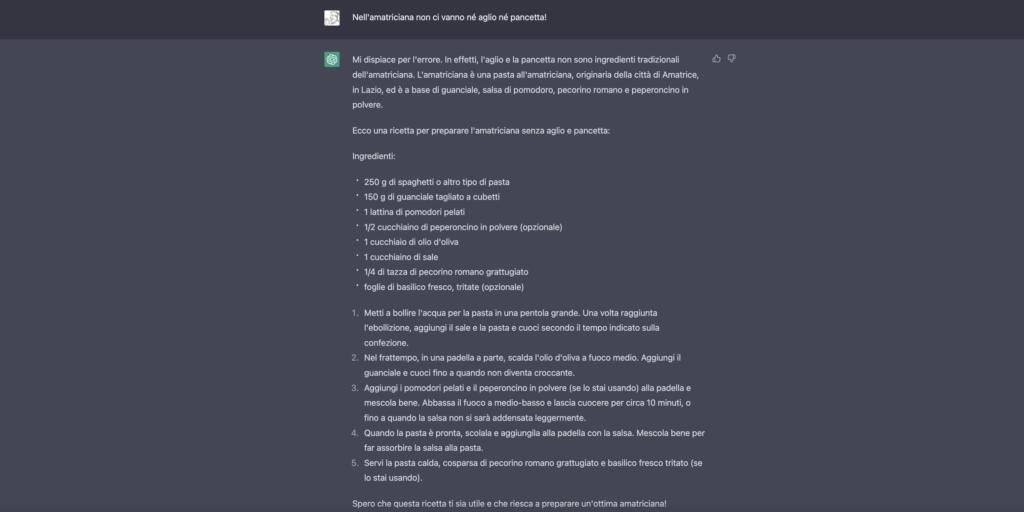

E in cucina come se la cava? Non benissimo! Se si chiede una ricetta tipicamente italiana – in questo caso la pasta all’Amatriciana (con particolare attenzione sul sugo) – la risposta è molto “americanizzata”. Alla fine di un lungo dialogo, fatto di correzioni da parte dell’utente, siamo arrivati alla conclusione con una ricetta molto simile a quella prevista dalla tradizione di quel piatto.

Dunque, la versione originale prevedeva l’utilizzo di cipolla, aglio e pancetta (come possibile alternativa al guanciale). Dopo due correzioni, siamo riusciti a riportare l’intelligenza artificiale di ChatGPT sulla retta via, con una ricetta (e un procedimento) molto più simile all’originale storico della pasta all’Amatriciana. Si tratta, ovviamente, di problematiche non gravi. Ma siamo sicuri di voler affidare le nostre domande a risposte imperfetti e perfettibili?