Cos’è questa storia di OpenAI che ha aperto all’uso militare dei suoi strumenti

Il cambio di policy è avvenuto nella notte tra il 9 e il 10 gennaio. C'è da preoccuparsi?

16/01/2024 di Enzo Boldi

Oltre alle elezioni, il 2024 – come molti altri anni – è condizionato dalla guerra. Da quei conflitti di cui si parla quotidianamente sulle prime pagine di tutti gli organi di informazione (prima era quello in Ucraina, ora quello tra Israele e Hamas su Gaza) a quelli di cui, ancora oggi, si parla ancora molto poco. Abbiamo più volte parlato di come l’intelligenza artificiale abbia avuto un ruolo primario in numerose guerre moderne e la notizia della nuova policy che apre all’uso militare degli strumenti sviluppati da OpenAI non può che provocare un impennata verso l’alto dell’indice delle preoccupazioni globale. Ma è veramente così?

LEGGI ANCHE > OpenAI sta realmente agendo per evitare che l’AI sia utilizzata per ingerenze elettorali?

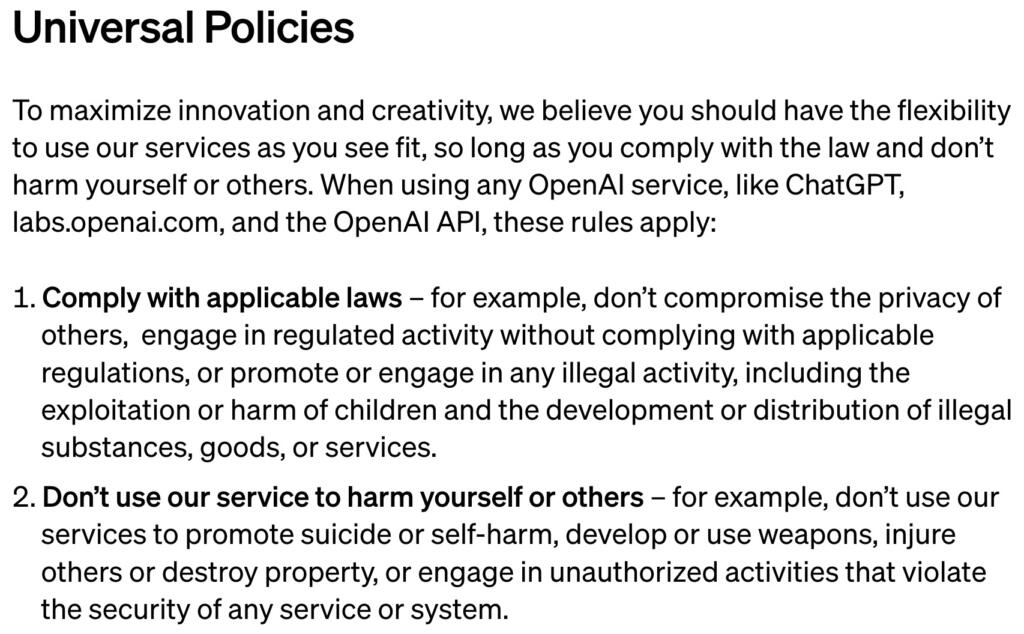

La modifica è arrivata nel silenzio generale, senza grandi annunci da parte dell’azienda di San Francisco. Nel nuovo testo, all’interno del capitolo dedicato alle politiche universali, è sparito quel riferimento agli usi militare delle tecnologie sviluppate da OpenAI, ma sono rimasti in vigore alcuni principi relativi al divieto di usare questi sistemi per arrecare danni a se stessi e agli altri. E questo apre le porte a un contenitore dialettico molto interpretabile.

Cosa diceva la vecchia policy

Per capire in cosa consiste questa modifica della policy di OpenAI, dobbiamo recuperare il testo della vecchia. Per farlo, abbiamo utilizzato lo strumento di archiviazione delle pagine web (Internet Archive), prendendo la penultima versione (datata 31 dicembre 2023).

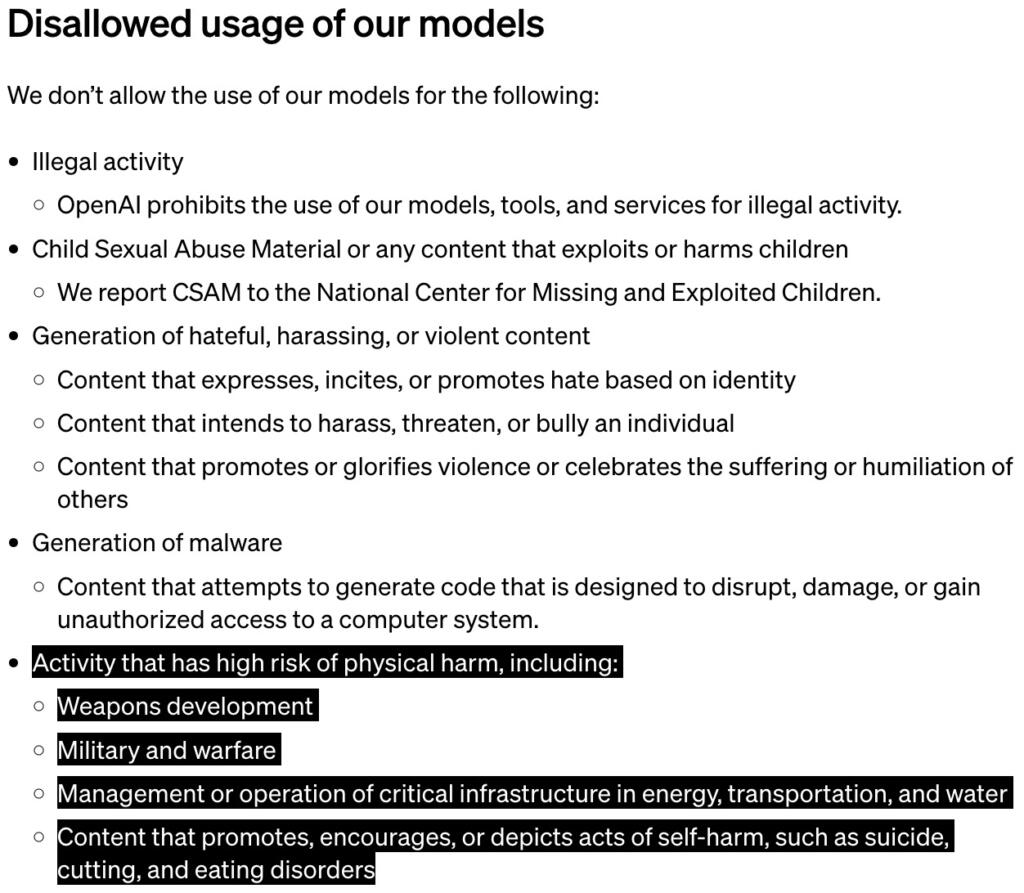

All’interno del capitolo dedicato all’utilizzo non consentito dei modelli sviluppati dall’azienda di San Francisco, c’è un esplicito riferimento all’inibizione di attività in grado di provocare danni fisici. Nello specifico, era scritto:

«Attività che presentano un alto rischio di danni fisici, tra cui: sviluppo di armi, militare e guerra, gestione o funzionamento di infrastrutture critiche nei settori dell’energia, dei trasporti e dell’acqua e contenuti che promuovono, incoraggiano o descrivono atti di autolesionismo, come il suicidio, l’escissione e i disturbi alimentari».

Dunque, c’era un esplicito riferimento al divieto dell’uso militare di OpenAI e dei modelli sviluppati nel corso degli ultimi anni. Questo dettaglio, però, è sparito dall’ultima versione della policy universale sull’utilizzo degli strumenti dell’azienda.

Uso militare di OpenAI, cosa dice la nuova policy

La modifica risale al 10 gennaio scorso, con cambiamenti sia nel formato che negli elenchi di cosa è lecitamente possibile fare con strumenti come ChatGPT e DALL·E.

Dunque, si fa riferimento al divieto di utilizzare ChatGPT, labs.openai.com e l’API OpenAI, per danneggiare se stessi o gli altri. Un paradigma pressoché uguale alla versione precedente della policy. Nell’elenco, però, sparisce ogni riferimento all’uso militare di questi strumenti:

«Ad esempio, non utilizzare i nostri servizi per promuovere il suicidio o l’autolesionismo, sviluppare o utilizzare armi, ferire altri o distruggere proprietà o intraprendere attività non autorizzate che violino la sicurezza di qualsiasi servizio o sistema».

Un’omissione che sembra poter essere molto pericolosa, anche se da OpenAI hanno immediatamente provato a smussare gli angoli di questa ispida parete. In una risposta scritta dal portavoce dell’azienda di San Francisco, Niko Felix, a The Intercept non è stata fatta una gran luce su questo argomento. Si sostiene che la parola “danno” riferito agli usi delle tecnologie di intelligenza artificiale sia molto ampio e che, dunque, dovrebbe contenere anche i possibili utilizzi in chiave bellica. Ma non è scritto e, dunque, si rimanda a una legislazione locale sulle scelte che gli eserciti (e le Difese) dei vari Paesi possono prendere.