Dalle API agli hashtag: come è stato individuato il rapporto tra social e pedopornografia

I ricercatori dello Stanford Internet Observatory hanno incrociato moltissimi dati per poter scoprire la vastità e il modus operandi di questa "community" che utilizzava le principali piattaforme come "vetrina"

08/06/2023 di Enzo Boldi

I dati emersi dall’inchiesta del Wall Street Journal sono inquietanti, soprattutto perché si tratta di un fenomeno che risulta essere corroborato (e non cassato) dalle principali piattaforme di social networking. Perché la pedopornografia sui social, purtroppo, è una realtà che continua a esistere. Anzi, è fagocitata dall’utilizzo di vecchi e nuovi strumenti digitali e dall’affidamento, sempre più totalizzante, agli algoritmi. Intelligenze artificiali che, invece di fermare il traffico e il commercio di materiali sessualmente espliciti con protagonisti/vittime minorenni, lo alimentano attraverso hashtag che portano a “suggerimenti” in grado di allargare il cerchio. Le ultime evidenze emergono da una ricerca, citata anche dal WSJ, dello Stanford Internet Observatory che ha spiegato come tre suoi ricercatori siano stati in grado di fornire il quadro della situazione.

LEGGI ANCHE > Instagram ha “raccomandato” contenuti pedopornografici alle reti di pedofili

Oltre ai dati che mostrano come Instagram – a causa del suo algoritmo – abbia alimentato la rete attraverso suggerimenti di amicizia basati sull’utilizzo di determinati hashtag (ora bannati), la ricerca ha mostrato che il fenomeno criminale della pedopornografia sui social coinvolga anche molte altre piattaforme, seppur in modo limitato rispetto a quanto rilevato su IG. C’è Twitter, per esempio, in cui il numero di “account” che commercializzano (all’esterno della piattaforma) contenuti di minori in comportamenti sessualmente espliciti si è ridotto con il passare del tempo, ma il problema resta vivo. Così come su Snapchat, Discord e molto altro. Per non parlare dei canali privati su Telegram.

Pedopornografia sui social, la ricerca su Instagram

Ma come i tre ricercatori (David Thiel, Renée DiResta and Alex Stamos) dello Stanford Internet Observatory (SIO) sono riusciti a individuare gli account protagonisti del commercio di materiale pedopornografico. Il metodo è ben spiegato all’interno del report pubblicato ieri, mercoledì 7 giugno. Per quel che riguarda Instagram, tutto è partito dagli hashtag (che non citeremo). I ricercatori hanno creato degli account iniziando a utilizzare e a ricercare contenuti con quelle “marcatori”, per fare una scoperta: era lo stesso social a “suggerire” di stringere amicizia con altri account che utilizzavano quegli stessi hashtag.

Una dinamica comune per Instagram, che cerca di creare community basate sugli stessi interessi. Qui non si parla di “interessi”, ma di reati. Sta di fatto che scavando all’interno di questi suggerimenti, i ricercatori del SIO hanno individuato 405 account legati a questa cerchia di pedopornografia. Tutti pronti a commercializzare CSAM (Child sexual abuse material) e SG-CSAM (Self-generated child sexual abuse material).

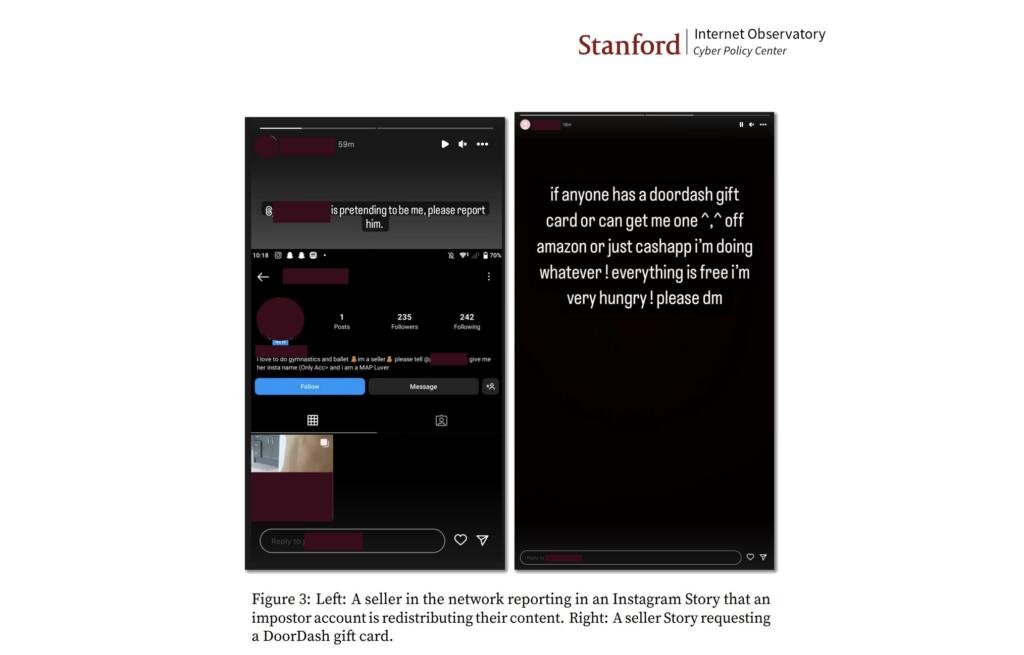

E, proseguendo nella loro ricerca, i ricercatori si sono trovati di fronte a profili come questi. Secondo chi ha condotto questo studio, la maggior parte degli account sono gestiti proprio da minori che hanno messo in vendita (utilizzando Instagram e non solo come vetrina) i propri contenuti sessualmente espliciti. Con tanto di menù, per rispondere alle richieste dei “compratori” pedofili. Ovviamente, i contenuti venivano inviati al “compratore” dopo la certificazione dell’avvenuto pagamento, ma non su Instagram. Le altre piattaforme, comprese quelle per l’invio di file “pesanti” come Dropbox e Mega.

Il metodo e gli strumenti utilizzati

Come detto, però, il report non riguardava solamente il social di Meta. I ricercatori hanno cercato di trovare queste trame criminali anche altrove. Per quel che riguarda Instagram e TikTok (dove il fenomeno è contenuto, praticamente vicino allo zero), il controllo è avvenuto manualmente cercando hashtag e url. Per Twitter, dove la pornografia infantile sta diminuendo, si è utilizzato il sistema delle API per identificare i profili. Il sistema più sicuro, proprio perché riesce a portare a una “scansione” maggiore è certamente quello delle Application Programming Interface, ma si tratta di dati che non sono presenti né su Instagram né su TikTok. Sta dio fatto che questi metadati pubblici sono stati salvati all’interno dello strumento Zeeschuimer per poi poter procedere all’analisi. Questo ha portato all’identificazione degli account, con i profili caricati all’interno del tool Maltego che raccoglie, elabora e analizza quelle informazioni provenienti da diverse fonti (social network, database pubblici, e motori di ricerca). Infine, quei dati sono stati utilizzati su Sociallinks per la creazione di grafici.

Questi grafici sono stati molto utili ai ricercatori del SIO per individuare quali account che commercializzavano pedopornografia sui social fossero presenti su una o più piattaforme. Non è un caso che, infatti, in molti casi nelle bio Instagram erano riportati collegamenti a canali Telegram, Discord, Mastodon e altre piattaforme. Perché se social “tradizionali” come Twitter e IG sono stati la vetrina per mettere in vendita quei contenuti, lo scambio di materiali avveniva sempre al di fuori di queste piattaforme.